| 现场环境 |

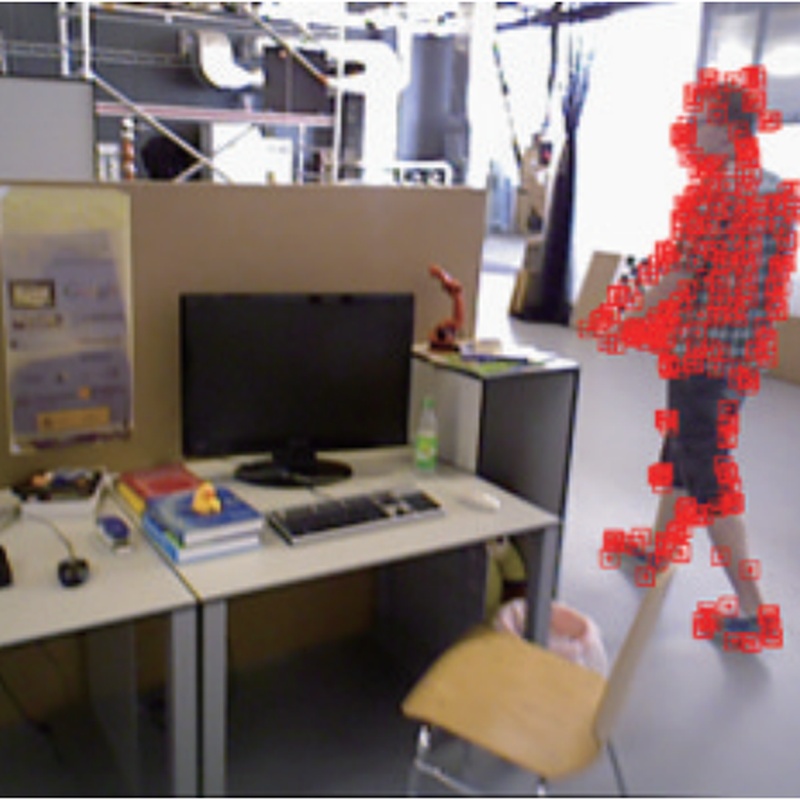

在室内动态环境中,使用RGB-D相机进行视觉SLAM建图,适用于机器人导航、无人机巡检等场景。 |

| 使用对象 |

室内环境中的动态物体(移动的人、车辆等)和静态物体(家具、墙壁等) |

| 使用目的 |

通过精准检测和剔除动态特征点,提高视觉SLAM系统在动态环境中的建图精度和位姿估计准确性。 |

| 硬件配置 |

CPU:Intel(R) Core i7-12700H 2.30GHz;GPU:NVIDIA GeForce RTX 3070Ti Laptop;内存:8GB;操作系统:Ubuntu 20.04。 |

| 硬件兼容 |

无

|

| 软件配置 |

操作系统:Ubuntu 20.04;依赖库:PyTorch 1.8.1;编程语言:Python 3.8。 |

| 软件兼容 |

无

|

| 输入数据 |

RGB-D图像帧,分辨率640×480像素。 |

| 输出数据 |

相机位姿、稠密点云地图、动态物体检测结果。 |

| 样本获取 |

在TUM数据集和Bonn数据集上进行实验,包含低动态和高动态场景的6组数据集。 |

| 测试结果 |

在TUM数据集上,LDF-SLAM的绝对轨迹误差的均方根误差(RMSE)相比ORB-SLAM3降低了44.5% - 95.9%;在Bonn数据集上,RMSE降低了18.18% - 98.99%。 |

| 执行速度 |

检测速度为19.1ms/次。 |

| 资源消耗 |

在上述硬件配置下,CPU平均占用率约70%,GPU平均占用率约80%,内存使用量约5GB。 |

| 源码类型 |

本算法有Python版本源码,使用售卖方式进行授权。 |

| 文件大小 |

算法程序文件约50K,权重文件约120M。 |

| 相关备注 |

无 |