| 现场环境 |

在室内环境中,使用Kinect相机获取RGB-D视频流,相机保持平稳移动,避免出现明显抖动,不对场景中的物体进行重复录制。 |

| 使用对象 |

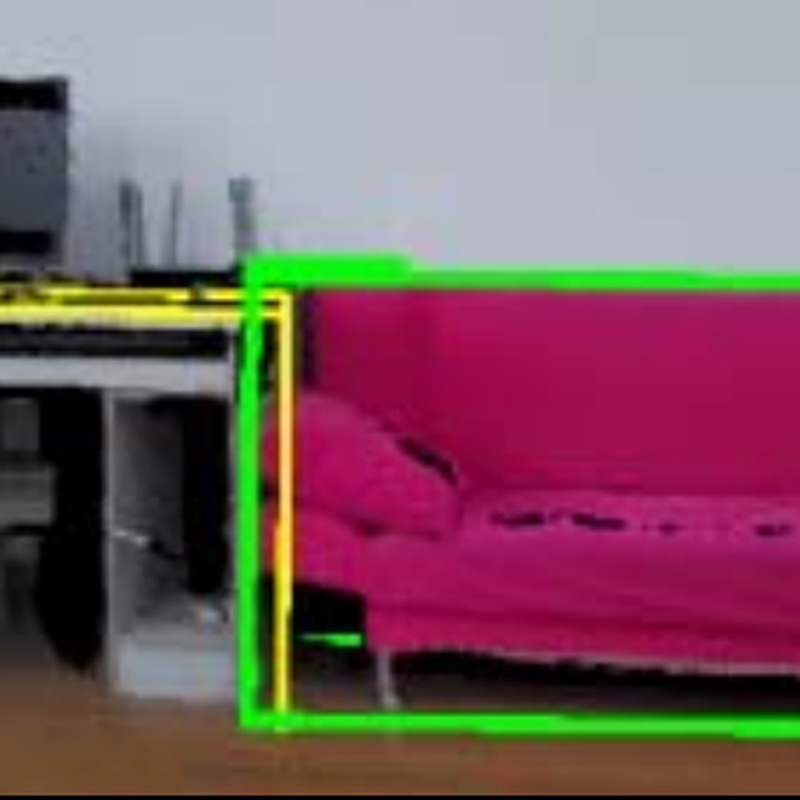

室内场景中的各类物体,如沙发、桌子、椅子等常见家具。 |

| 使用目的 |

高效检测室内场景中的3D目标物体,提高目标检测的准确性和效率,减少检测时间,适用于室内机器人导航、增强现实等场景。 |

| 硬件配置 |

CPU:Intel Core i5-7th

GPU:无(可选)

内存:4GB

摄像头:Kinect Azure DK相机 |

| 硬件兼容 |

无

|

| 软件配置 |

操作系统:Centos

编程语言:Python 3.5.3

深度学习框架:Pytorch 1.1

编译器:g++ 5.4.0

CUDA:9.0 |

| 软件兼容 |

无

|

| 输入数据 |

RGB-D视频流中的彩色图像帧和点云数据,图像分辨率为640×640像素,以jpg格式存储。 |

| 输出数据 |

检测到的3D目标物体的类别、位置、朝向信息 |

| 样本获取 |

使用Kinect相机在不同室内环境中录制RGB-D视频流,获取多段视频流数据,每段视频流包含若干帧图像及对应的点云数据,用于训练和测试。 |

| 测试结果 |

与基于VoteNet的逐帧检测方法相比,本文方法的检测结果准确,且检测时间大大缩短。例如,对于一段63帧的视频流,本文方法检测耗时35.95秒,而VoteNet逐帧检测耗时75.60秒。 |

| 执行速度 |

关键帧提取耗时11.45秒,关键帧检测耗时4.50秒,其余帧插值检测耗时20.00秒,总检测时间35.95秒(以63帧视频流为例)。 |

| 资源消耗 |

4核CPU,计算占比平均约60%;4GB内存,使用占比约50%。 |

| 源码类型 |

本算法有Python版本源码,可提供授权使用。 |

| 文件大小 |

算法程序文件30K,权重文件220M。 |

| 相关备注 |

本算法针对室内环境的RGB-D视频流数据,能够高效地检测出视频流中各帧的3D目标物体。 |